-

Python.org – основной сайт. Тут можно скачать актуальный python на windows/linux/mac os, посмотреть документацию

- Гвидо ван Россум – творец языка. По сути аналог Линус Торвальдса для Linux. 1989 год Голландский разработчик Гвидо ван Россум в качестве хобби-проекта во время рождественских каникул создает язык программирования Python. Шутка зашла слишком далеко: сегодня это самый популярный язык программирования. По данным GitHub, в 2024 Python впервые стал лидером по количеству активных пользователей, что связано с его широкой применимостью в областях анализа данных, машинного обучения, ИИ и автоматизации. Все основные большие языковые модели используют Python.

- Python – the second best language for everything. И это действительно так, включая новые-модные devops, AI, BigData, autotests. При этом нельзя забывать, что 1) любой язык в конечном счете является лишь инструментом для решения задачи и какой-то инструмент может быть лучше, чем текущий 2) зная один язык, проще изучить новый. Подробнее в статье про программирование.

- В статье про алгоритмы и структуры данных решено много python-задач Алгориртмы и структуры данных, оценка сложности алгоритмов (асимптотическая оценка, оценка Big O)

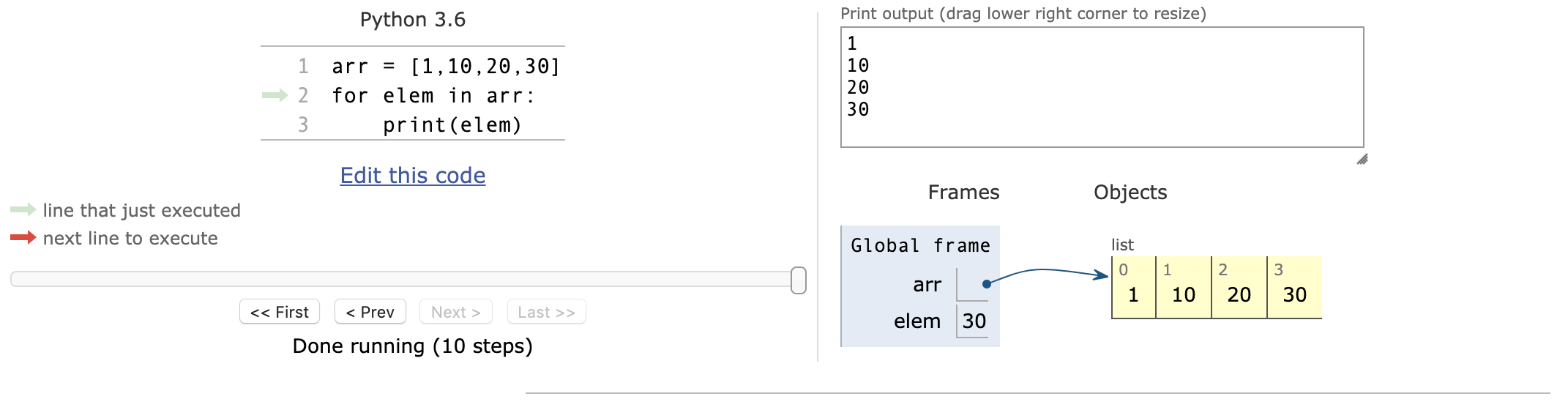

- онлайн интерпретаторы

- repl.it

- https://pythonide.online/

- Web сравнение кода/текста между собой https://text-compare.com

- Культовая книга: Изучаем Python.| Лутц Марк

- PEP8 – правила по написанию кода, важно соблюдать. Подробнее в Coding: архитектура, программирование и разработка, подходы, best practices, devops, containers (k8s, docker, nomad, mesos), releases, waterfall/agile, scrum, sprints, CI/CD, Serverless computing, Microservice Architecture Помогут:

- (python, coding best practices) formatter’ы типо black и autopep8, автоматически форматирующие код в соответствие PEP8 при сохранении/изменении (Visual Studio Code -> Format on save)

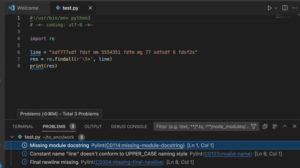

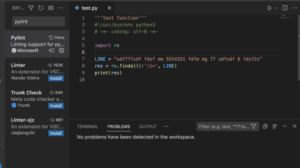

- (python, coding best practices) рекомендуется использовать линтеры/linters, которые проверят ваш код напр. pylance, pylint, flake8 (особенно хорош) для Python – все вместе (и не только они) легко включаются в VisualStudio Code. Из спорного однозначно

- размер строки менее 80 символов – это для экранов в прошлом, на мой экран помещается в три раза больше. Поэтому 120 от PyCharm более логичны.

- flake8 – command palette -> open user settings (JSON

“python.linting.flake8Args”: [

“–max-line-length=120”

],

- flake8 – command palette -> open user settings (JSON

- выдавать warning о том, что import не наверху файла, если все что перед ним это append/insert специфичного пути

- если линтеры не работают – проверь что для файла выставлено trust (внизу в индикаторах ошибок надпись Restricted Mode).

- размер строки менее 80 символов – это для экранов в прошлом, на мой экран помещается в три раза больше. Поэтому 120 от PyCharm более логичны.

- одноименный чекер. Пример стилистики описан в статье про лучшие практики программирования.

- У Python одна из лучших документаций в мире.

- Название Python не от змеи, а от комедийного шоу.

- Python2 оффициально deprecated

/home/user/.local/lib/python2.7/site-packages/paramiko/transport.py:33: CryptographyDeprecationWarning: Python 2 is no longer supported by the Python core team. Support for it is now deprecated in cryptography, and will be removed in the next release.

- Python3 по факту python 3000. В этой версии значительно улучшена архитектура. На сегодняшний день все основные библиотеки поддерживают 3’ю версию.

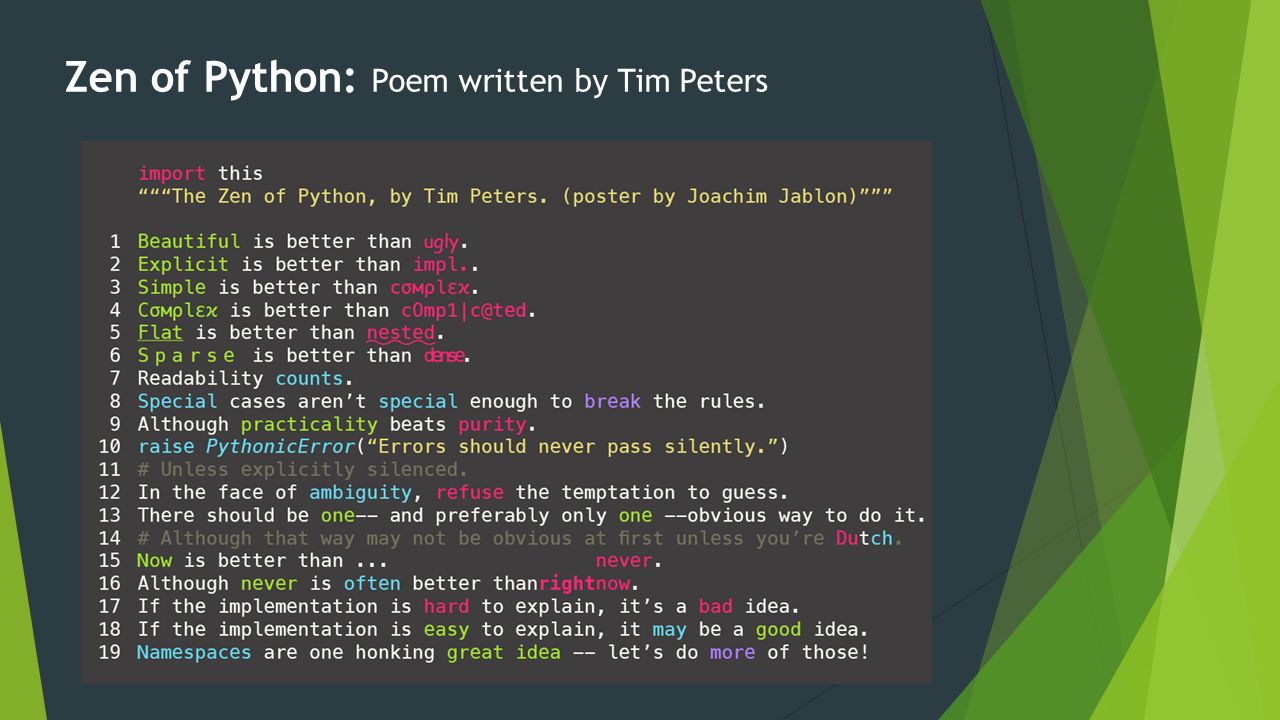

- (Python, best practices) Zen of python (рекомендуемые best practice) можно прочитать по import this

- The core principle in Python is DRY (Don’t Repeat Yourself)

Beautiful is better than ugly. Explicit is better than implicit. Simple is better than complex. Complex is better than complicated. Flat is better than nested. Sparse is better than dense. Readability counts. Special cases aren't special enough to break the rules. Although practicality beats purity. Errors should never pass silently. Unless explicitly silenced. In the face of ambiguity, refuse the temptation to guess. There should be one-- and preferably only one --obvious way to do it. Although that way may not be obvious at first unless you're Dutch. Now is better than never. Although never is often better than *right* now. If the implementation is hard to explain, it's a bad idea. If the implementation is easy to explain, it may be a good idea. Namespaces are one honking great idea -- let's do more of those!

- Python GUI automation – pywinauto/pyautogui – автоматизация GUI.

pywinauto is a set of python modules to automate the Microsoft Windows GUI. At its simplest it allows you to send mouse and keyboard actions to windows dialogs and controls. PyAutoGUI works on Windows, macOS, and Linux, and runs on Python 2 and 3.

- Python wx – графика, вполне себе работает в связке с X Windows System, работал с инструментом на базе wx написанном поверх Python2

- Python 3.8-3.9 требуют установленного Service Pack 1 на Windows 7

- В отличии от многих других языков отступ (indentation) в python очень важен (обозначает блок кода, как скобки в php/c) и неправильный отступ может приводить к ошибкам. В этом есть большой плюс – код по умолчанию должен быть «красивым».

- Python – язык с динамической типизацией – переменным не обязательно задавать тип. При этом это возможно и даже нужно – см. ниже поиском по типизации.

- Переменные в python являются ссылками на область памяти (подробнее в описании функции id)

- Интерпретатор Python делает поиск значения переменной в последовательности областей видимостей (scope, namespace) по приоритету до первого совпадения, это называется правило LEGB. Из-за такой приоритезации можно переназначить переменные, уже определенные во встроенных/внешних функциях.

- L (local) – в локальной функции – locals()

- E (enclosing) – в функции, включающей нашу локальную функцию

- G (global) – в общем пространстве скрипта – globals()

- B (built-in) – во встроенных функциях

>>> str <class 'str'> >>> str=[] >>> str [] >>> del str # удаляем переменную str >>> str <class 'str'>

Поэтому проверка объявления переменной (иногда нужно в коде) осуществляется поиском строки с названием переменной в необходимом scope. Если строка s1 содержится в строке s2, то говорят, что строка s1 является подстрокой для строки s2. Другими словами, оператор in определяет является ли одна строка подстрокой другой.

var1_global = "exist"

if 'var1_global' in globals():

print("yes")

- В python работает механизм garbage collection. Garbage collection – процесс, который удаляет ненужные элементы. К примеру, чистит память (старые участки) при переназначении переменных – на участки памяти не ссылаются переменные, их можно высвобождать.

- None – это нулевой/Null элемент.

Noneв Python позволяет представитьnullпеременную, то есть переменную, которая не содержит какого-либо значения. Другими словами,None– это специальная константа, означающая пустоту.- Обратите внимание, что функции, не возвращающие значений, на самом деле, в Python возвращают значение None.

- Все переменные, которым присвоено значение

None, ссылаются на один и тот же объект типаNoneType. - Объекты, существующие в единственном экземпляре ((такие, как None)), называются синглтонами.

- Создание собственных экземпляров типа

NoneTypeнедопустимо. - Для того, чтобы проверить значение переменной на None, мы используем либо оператор is, либо оператор проверки на равенство ==. Предпочтительным является is. Сравнение

Noneс любым объектом, отличным отNone, дает значениеFalse. В том числе ЗначениеNoneне отождествляется с значениями0,False,''. None– это объект специального типа данныхNoneType.>>> a = None >>> type(a) <class 'NoneType'>

- Чаще всего результат сравнений

isи==одинаков, но есть исключения

list1 = [1, 2, 3] list2 = list1.copy() print(list2 is list1) print(list2 == list1) False True

- Заполненный чем то элемент при этом является True и этим можно пользоваться (главное не думать, что если массив заполнен False, то он будет считаться False):

sm_str = "haha"

if sm_str:

print("{}".format(sm_str))

# вместо

if sm_str != "":

print("{}".format(sm_str))

- Проверить что в массиве нет False элементов можно через стандартную функцию in.

if False not in l: res = True else: res = False

Обучение

- Базовое обучение на py4e.com от Dr. Charles Russell Severance – создателя популярной книги python for everybody и одноименного курса на своем сайте и coursera

- python for network engineers

Версии

- Cython – компилятор python кода like python, но с трансляцией в производительный C/C++ код. Используется для написания C расширений для Python. “Использование Cython — один из самых мощных способов оптимизации”

- Код Cython преобразуется в C/C++ код для последующей компиляции и впоследствии может использоваться как расширение стандартного Python или как независимое приложение со встроенной библиотекой выполнения Cython.

- Cython is a Python compiler that makes writing C extensions for Python as easy as Python itself. Cython is based on Pyrex, but supports more cutting edge functionality and optimizations. Cython translates Python code to C/C++ code, but additionally supports calling C functions and declaring C types on variables and class attributes. This allows the compiler to generate very efficient C code from Cython code.

- CPython – эталонная (классическая) реализация языка. Интерпретатор написан на C.

- Jython – специальная версия Python (значительно менее популярная канонической) для виртуальной машины Java позволяет интерпретатору выполняться на любой системе, поддерживающей Java, при этом классы Java могут непосредственно использоваться из Python и даже быть написанными на Python.

- IronPython – специальная версия Python (значительно менее популярная канонической) на основе C#

- MicroPython – lightweight реализация для микроконтроллеров с малым потреблением памяти, процессора и питания. Пример девайса есть на канале Dan Bader (известный популяризатор Python).

it is compact enough to fit and run within just 256k of code space and 16k of RAM

aritigicial intelligence AI

-

- (AI, python) самые популярные ML-библиотек для искуственного интелллекта/aritigicial intelligence AI: PyTorch, TensorFlow, Scikit-learn

-

- (AI, python) Пример базовой работы с openai (chatgpt) через python:

- устанавливаем библиотеку,

- в переменные среды добавляем api ключ – пример для linux, но можно и в windows; в целом можно указать и в скрипте при инициализации клиента

- скриптом делаем запрос и получаем ответ

pip install openai

export OPENAI_API_KEY="your_api_key_here"

from openai import OpenAI #(with key) client = OpenAI(api_key="ТВОЙ_КЛЮЧ_ЗДЕСЬ") client = OpenAI() response = client.chat.completions.create( model="gpt-4o-mini", # или "gpt-3.5-turbo" messages=[{"role": "user", "content": "1+1= ?"}] ) print(response.choices[0].message.content) - (AI, python) Пример базовой работы с openai (chatgpt) через python:

Frameworks

Web фреймворки:

- Flask для простых проектов

- Django для всего остального

- FastAPI

пример работы фреймворка на примере fastAPI: ты создаешь экземпляр класса fastAPI, создаешь асинхронную функцию, делаешь роут/вызываешь application логику, отдаешь response пользователю от application.

- При этом ты не запускаешь никак созданный код – их запускает фрейморк/получает результат/отдает клиенту, от нас это скрыто. Поэтому чтобы все это заработало на созданную асинхронную функцию надо навесить декоратор фреймворка типа app-get – называется это паттерн registry – твои функции не будут вызваны фреймворком/он о них не узнает, пока ты не добавишь нужный декоратор перед ними тем самым добавив свой код в реестр/registry фреймворка.

- Из этого же вывод что фреймворк реализует принцип инверсии управления – в отличии от библиотеки при работе с фреймворком твой код запускает фреймворк/обрабатывает его результат и возвращает клиенту, а не наоборот – ты вызываешь код библиотеки, ты обрабатываешь результат и возвращаешь клиенту, но в случае с библиотеками и в случае с фреймворками ты должен следовать каким то правилам при работе с ними (от банального что передавать на вход). В том числе это упрощает обработку – ты пишешь асинхронную функцию, но вызывает ее фреймворк и фреймворк уже под компотом реализует асинхронность (подробнее о асинхронности в целом отдельно) без твоего непосредственного участия.

Install

CentOS 7

Установка python3.6 (поддерживает String Interpolation в виде format и f-strings) на Ubuntu 14.04.

sudo yum install https://centos7.iuscommunity.org/ius-release.rpm sudo yum install python36 python3.6 -V sudo apt install python3-pip sudo yum install python36u-pip # ставим pip и setuptools sudo pip3.6 install --upgrade pip # обновляем его sudo pip3.6 install virtualenv sudo pip3.6 install requests # ставим пакет requests sudo pip3.6 install beautifulsoup4 sudo python3 -m pip install virtualenv # альтернатива # PIP2 sudo apt install python-pip sudo pip2 install PyYAML

CentOS 6

Установка python3.6 на CentOS 6.

sudo yum install https://centos6.iuscommunity.org/ius-release.rpm sudo yum install python36u python3.6 -V == other same as CentOS 7 ==

Ubuntu 14.04

Установка python3.6 на Ubuntu 14.04.

sudo add-apt-repository ppa:deadsnakes/ppa sudo apt-get update sudo apt-get install python3.6 sudo apt-get install python3-pip # ставим pip и setuptools == other same as CentOS 7 ==

После установки в коде (#!/usr/bin/env python3.6) или при запуске (python3.6 <script>) указываем конкретную версию. Так же можно сделать эту версию версией по умолчанию для python3 (не рекомендую т.к. на него полагается shell – стоит ввести фигню в консоли чтобы это увидеть) или даже для “просто” python (еще меньше рекомендую) используя утилиту update-alternatives.

~$ python3 -V Python 3.4.3 ~$ sudo update-alternatives --install /usr/bin/python3 python3 /usr/bin/python3.6 1 update-alternatives: using /usr/bin/python3.6 to provide /usr/bin/python3 (python3) in auto mode ~$ sudo update-alternatives --install /usr/bin/python3 python3 /usr/bin/python3.4 2 update-alternatives: using /usr/bin/python3.4 to provide /usr/bin/python3 (python3) in auto mode ~$ sudo update-alternatives --config python3 There are 2 choices for the alternative python3 (providing /usr/bin/python3). Selection Path Priority Status ------------------------------------------------------------ * 0 /usr/bin/python3.4 2 auto mode 1 /usr/bin/python3.4 2 manual mode 2 /usr/bin/python3.6 1 manual mode Press enter to keep the current choice[*], or type selection number: 2 update-alternatives: using /usr/bin/python3.6 to provide /usr/bin/python3 (python3) in manual mode ~$ python3 -V Python 3.6.8

Shebang возможен с конкретной версией python. Важно использовать env – такая запись универсальнее статического задания интерпретатора т.к. env будет находить python автоматически.

#!/usr/bin/env python3.7

Если при установке shebang выдает ошибку, то нужно очистить скрипт от служебного символа \r или ^M. Причем не обязательно он в конце строки на которую ругается. Оболочка интерпретирует эти символы CR как аргументы.

/usr/bin/env: «python3.7\r»: Нет такого файла или каталога

No such file or directory

# cat -v test.py | head -n 2

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

# cat -v test_old.py | head -n 2

#!/usr/bin/env python3^M

# -*- coding: utf-8 -*-^M

Чаще всего помогает запуск не через shebang, а напрямую указав интерпретатор (он эти символы игнорирует). Но правильнее удалить их.

Пример скрипта для очистки.

with open('test.py', 'rb+') as f:

content = f.read()

f.seek(0) # переход в самое начало файла

f.write(content.replace(b'\r', b''))

f.truncate()

PIP (установка и использование)

Огромное количество модулей входит в стандартную библиотеку python. Те, которые не входят, обычно можно найти в pip, за редким исключением.

Просмотр установленных библиотек.

pip3 list Package Version ---------- ---------- certifi 2018.11.29 chardet 3.0.4 idna 2.8 pip 18.1 requests 2.21.0 setuptools 39.0.1 urllib3 1.24.1

Просмотр установленных библиотек/модулей и сохранение их в файл с возможностью последующего использования как конфигурации/snapshot.

pip3 freeze # save to file pip3 freeze > requirements.txt

Установка модулей делается через установку из источника, easy_install или pip. Лучшим вариантом насколько понимаю является pip – это аналог gem в Ruby. Он требует отдельную установку себя like “sudo pip3.6 install requests”.

Установка библиотеки.

sudo pip3 install requests # ставим пакет requests sudo pip3 install beautifulsoup4

Установка библиотеки из файла whl (требует разрешение конфликтов).

pip3 install pywin32-228-cp37-cp37m-win_amd64.whl

pip3 install cffi-1.14.3-cp37-cp37m-win_amd64.whl

pip3 install pycparser-2.20-py2.py3-none-any.whl

Установка нескольких библиотек на основе списка в файле (напр. из вывода pip3 freeze).

#pip3 install -r requirements.txt #cat requirements.txt Pillow

Обновление библиотеки.

sudo pip3 install -U requests

Удаление библиотеки.

sudo pip3 uninstall requests

Ошибки

Если не получается поставить pip с ошибкой “No package python-pip available. Error: Nothing to do”, то нужно поставить репу ius.

sudo yum install https://centos7.iuscommunity.org/ius-release.rpm

Если в качестве результата при установке пакета выдает “Consider using the `–user` option or check the permissions.”, значит нужно запускать из под sudo.

sudo pip3.6 install requests

Если выдает “sudo: pip3.6: command not found”, то надо каждый раз при использовании pip указывать полный путь или сделать symbolic link.

sudo /usr/local/bin/pip3.6 install requests

Если выдает timeout, то нужно проверить сеть (iptables, proxy, etc).

Retrying (Retry(total=0, connect=None, read=None, redirect=None, status=None)) after connection broken by 'ConnectTimeoutError(<pip._vendor.urllib3.connection.VerifiedHTTPSConnection object at 0x7f443823edd8>, 'Connection to pypi.org timed out. (connect timeout=15)')': /simple/pytest/

Если не удается установить библиотеку т.к. она не собрана под нашу систему – можно собрать эту библиотеку. При сборке могут поднадобиться системные библиотеки (напр. MS Visual C++).

pip3 install bcrypt-3.2.0-cp36-abi3-win_amd64.whl bcrypt-3.2.0-cp36-abi3-win_amd64.whl is not a supported wheel on this platform.

python setup.py build

python setup.py install

error: Microsoft Visual C++ 14.0 is required. Get it with "Microsoft Visual C++ Build Tools": https://visualstudio.microsoft.com/downloads/

http://go.microsoft.com/fwlink/?LinkId=691126&fixForIE=.exe.

Интерпретатор

Просмотр версии, запуск в интерактивном режиме. Другие опции можно посмотреть в man python.

$ python -V # версия второго Python 2.7.10 $ python3 -V # версия третьего Python 3.7.2 $ python3 # запуск в интерактивном режиме Python 3.7.2 (v3.7.2:9a3ffc0492, Dec 24 2018, 02:44:43) [Clang 6.0 (clang-600.0.57)] on darwin Type "help", "copyright", "credits" or "license" for more information. >>> #Простейшая математика в интерактивном режиме >>> x=6 >>> print(x) 6 >>> x=x*6 >>> print(x) 36 quit() # выход

-u – важная опция, которая может пригодиться, особенно для длительно работающих скриптов, вывод которых нужно сохранять. При ее использовании вывод в файл при редиректе в файл (в том числе при использовании tee) будет происходить без буфферизации, как при выводе в shell. В итоге можно применять tail -f на файл и следить за процессом исполнения. В противном случае вывод будет записан в файл только после завершения скрипта. Тут подробнее и альтернативы.

-u Force stdin, stdout and stderr to be totally unbuffered. python -u

Reserved words

33 штуки

and del from None True

as elif global nonlocal try

assert else if not while

break except import or with

class False in pass yield

continue finally is raise

def for lambda return

Виртуальная среда

Позволяет изолировать разные проекты между собой как в рамках версий python, так и в рамках версий библиотек. Аналог vrf в сетях.

Существует несколько способов создания виртуальной среды python, не говоря даже про docker или виртуализацию уровня VM.

virtualenv

sudo pip3.7 install virtualenv

Прямое управление virtualenv возможно через команды утилиты virtualenv, но возможно и с использованием отдельных библиотек, например virtualenvwrapper.

virtualenv <PROJECT> # CREATE source <PROJECT>/bin/activate # ACTIVATE deactivate # DEACTIVATE

virtualenvwrapper – упрощает взаимодействие с виртуальными окружениями.

sudo pip3.7 install virtualenvwrapper

После установки добавляем в .bashrc и перезапускаем bash

export VIRTUALENVWRAPPER_PYTHON=/usr/local/bin/python3.7 export WORKON_HOME=~/venv . /usr/local/bin/virtualenvwrapper.sh

exec bash

Создание виртуального окружения с python3.7 по умолчанию.

mkvirtualenv --python=/usr/local/bin/python3.7 test_env

Удаление виртуального окружения

rmvirtualenv Test

Переход в виртуальное окружение

workon test_env

Выход из виртуального окружения

deactivate

Просмотр пакетов в виртуальном окружении

lssitepackages

Подключение/импорт библиотек/модулей/классов/функций

- Нежелательно использование import + * (лучше импортировать только то, что нужно).

- С помощью import подключаем всю системную библиотеку json

- С помощью import подключаем системные библиотеки json, sys, requests

- С помощью from + import из файла net_query.py (в директории исполнения текущего скрипта) подключаем только функцию model из пользовательской библиотеки net_query.

- С помощью from + import из файла LoadManager.py импортируем класс LoadManager.

import json import json, sys, requets from net_query import model from LoadManager import LoadManager

При этом мы так же могли бы импортировать весь модуль net_query и наоборот – часть (одну) функций модуля json. В любом случае импорта исполняется весь код модуля, просто:

- в случае from + import в пространство имен кода импортируется только объекты (переменные) кода конкретной импортируемой функции, а не весь модуль

- при import всего модуля обращение к объектам идет через модуль (import читает файл с модулем и создает объект этого модуля), а при from + import напрямую к объекту. По этой причине нельзя использовать from + import + * т.к. не будет понятно, откуда появился тот или иной объект в коде.

import statement - A statement that reads a module file and creates a module object. module object - A value created by an import statement that provides access to the data and code defined in a module.

import sys sys.argv sys.version from sys import argv, version argv version #DO NOT USE from sys import *

В случае длинного названия модуля можно использовать import совместно с as.

import concurrent.futures as cf

Например, код ниже импортирует функцию getcwd из модуля os под псевдонимом work_folder.

from os import getcwd as work_folder

При необходимости импорта из несистемной и нелокальной папки можно расширить пространство поиска библиотек используя sys.path.append:

sys.path.append('/home/user/new/some_dri')

from external_lib import external_lib_function

ЛИНТЕРы/linters/SAST

Теория о SAST описана тут.

Пример alert’ов linter pylance/pylint в VS Code. Включается простой установкой модуля (Extension -> pylint -> Install). Была только проблема с “The PyLint server crashed 5 times in the last 3 minutes. The server will not be restarted. See the output for more information.”, решилось установкой альтернативной версии модуля (pre-release вместо release).

Пример на простой код:

Исправленная версия:

Methods

Best practices

Отдельная статья про лучшие практики. В контексте python:

- Использовать Logging вместо print

- Использовать Debuggers (напр. встроенный в VS Code extension ms-python) для отладки

- Использовать Linters (напр. встроенный в VS Code extension ms-python pylance/pylint VS) Code) для написания industry standard кода (при возможности)

- Использовать f-string и Str.format вместо конкатенации (лучше f-string, подробнее ниже)

ConfigParser

Конфиг:

[settings] mode = default direction = server check_success = on check_directions = on

Парсинг конфига:

config = configparser.ConfigParser()

config.read('config.conf')

mode = config.get('settings', 'mode', fallback='default')

direction = config.get('settings', 'direction', fallback='client')

check_success = config.get('settings', 'check_success', fallback='on')

check_directions = config.get('settings', 'check_directions', fallback='on')

Logging

import logging

debug = True

if debug:

logging.basicConfig(stream=sys.stdout, level=logging.DEBUG)

log.debug("Doing something!")

Пример 2: вывод одного и того же лога с severity INFO (setlevel) в консоль (STDOUT) и файл.

import logging

logger = logging.getLogger()

formatter = logging.Formatter('%(asctime)s:%(levelname)s:%(filename)s:%(message)s')

fh = logging.FileHandler("log_fname.log")

fh.setFormatter(formatter)

logger.addHandler(fh)

lh = logging.StreamHandler(sys.stdout)

lh.setFormatter(formatter)

logger.addHandler(lh)

logger.setLevel( logging.INFO )

logger.debug('Debug message.')

logger.info('Info message.')

logger.warning('Warning message.')

logger.error('Error message.')

Пример 3: вывод DEBUG лога в файл, вывод INFO лога упрощенного формата в консоль. Причем глобальная команда setLevel на logger обязательна – это первичная глобальная выборка, без нее сообщения не попадут в handler. В глобальной выборке нужно указывать максимальный уровень, который будет применятся на уровне handlers – в данном случае DEBUG.

import logging

logger = logging.getLogger()

logger.setLevel( logging.DEBUG )

# add file handler

fh_formatter = logging.Formatter('%(asctime)s:%(levelname)s:%(filename)s:%(message)s')

fh = logging.FileHandler(log_fname_appmix)

fh.setLevel( logging.DEBUG )

fh.setFormatter(fh_formatter)

logger.addHandler(fh)

# add stdout handler

lh_formatter = logging.Formatter('%(asctime)s\t%(message)s', "%Y-%m-%d %H:%M:%S")

lh = logging.StreamHandler(sys.stdout)

lh.setLevel( logging.INFO )

lh.setFormatter(lh_formatter)

logger.addHandler(lh)

Этим способом логгирования пользуются библиотеки (напр. urllib3, paramiko), поэтому самое логичное в создаваемом коде использовать его же.

DEBUG:urllib3.connectionpool:Starting new HTTPS connection (1): 192.168.1.1:443 DEBUG:paramiko.transport:=== Key exchange agreements === DEBUG:paramiko.transport:Kex: curve25519-sha256@libssh.org DEBUG:paramiko.transport:HostKey: ssh-ed25519 DEBUG:paramiko.transport:Cipher: aes128-ctr DEBUG:paramiko.transport:MAC: hmac-sha2-256 DEBUG:paramiko.transport:Compression: none

pip install colorlog

Ошибка “TypeError: ‘RootLogger’ object is not callable” может иметь причиной простая ошибка синтаксиса – нужно обращаться к объекту log через метод, соответствующий logging severity (info, debug, etc), а не напрямую.

TypeError: 'RootLogger' object is not callable

log("Hello")

This is wrong. Correct is

log.info("Hello")

Пример настройки уровня логгирования и логгирование в файл (в том числе можно /dev/null).

# 1

import logging

import paramiko

logging.basicConfig()

logging.getLogger("paramiko").setLevel(logging.WARNING) # for example

# 2

paramiko.util.log_to_file("<log_file_path>", level = "WARN")

Logging функция

def log_start() -> logging.RootLogger:

'''Start logging and returning logging object'''

logger = logging.getLogger()

logger.setLevel(logging.DEBUG)

# add file handler

fh_formatter = logging.Formatter('%(asctime)s:%(levelname)s:%(filename)s:%(message)s')

fh = logging.FileHandler(config["log_fname"])

fh.setLevel(logging.DEBUG)

fh.setFormatter(fh_formatter)

logger.addHandler(fh)

# add stdout handler

lh_formatter = logging.Formatter('%(asctime)s\t%(message)s', "%Y-%m-%d %H:%M:%S")

lh = logging.StreamHandler(sys.stdout)

if config["debug_to_console_output"]:

lh.setLevel(logging.DEBUG)

else:

lh.setLevel(logging.CRITICAL)

lh.setFormatter(lh_formatter)

logger.addHandler(lh)

logger.debug(globals())

return logger

logger = log_start()

if i == 0: logger.critical(f'Script was started, logfile: {log_fname}') # Лучше CRICICAL чем INFO. Иначе by default будут SSH PARAMIKO и прочий мусор: Connected (version 2.0, client OpenSSH_7.4p1)

logger.debug("config_gen was started")

logger.handlers.clear() # для объявления новых файлов

SUPPRESS LOGS

Пример подавления логов на основе отключения warnings сообщений модуля paramiko.

warnings.filterwarnings(action='ignore',module='.*paramiko.*')

Есть так же множество других вариантов подавления логов – напр. всех.

python -W ignore foo.py

paramiko.util.log_to_file("/dev/null", level = "WARN")

Functions

# The first line of the function definition is called the header; the rest is called the body. The header has to end with a colon and the body has to be indented. The body can contain any number of statements. As you might expect, you have to create a function before you can execute it.

def fctn():

print("lol")

def some_funct(a,b): '''some description of function''' return(a+b) print(some_funct.__doc__)

some description of function

Аргументы (переменные) в функцию могут передаваться:

- позиционно – позиция аргумента при вызове функции соответствует описанию функции на входе. Используя * на входе есть возможность приема на входе функции всех переменных или только части и парсинга их уже в функции (по примеру ARGV из системных). Удобство такого подхода – можно написать сразу универсальную функцию, которая работает как с отдельной строкой, так и с массивом данных т.к. строка по умолчанию преобразуется в массив с одним элементом на входе в функцию.

some_funct(a,b)

>> def some_funct(*all_arg): >> print(all_arg) >> a=1 >> b=3 >> c=5 >> some_funct(a,b,c) (1, 3, 5)

>> def some_funct(a,*all_arg): >> print(a, all_arg) >> a=1 >> b=3 >> c=5 >> some_funct(a,b,c) 1 (3, 5)

- по ключу – позиция не важна, важен ключ, можно передавать переменные в произвольном порядке, главное, чтобы на входе функции ключи соответствовали передаваемым. При передаче чисел или значений Boolean крайне удобный функционал. При этом можно только часть переменных передавать по ключу, но обязательно, чтобы та часть, которая передается по ключу, была в конце, а позиционные аргументы в начале. Кроме того есть вариант передачи в функцию словаря вида ключ: значение используя ** при передаче переменных. В таком случае функция сама распарсит значения из ключей, как и при стандартном вызове функции. Используя же ** на входе в функцию можно принимать часть или все переменные в виде словаря.

some_funct(a=a,b=b)

some_funct(a,b=b)

ndr_benchmark_test(server='127.0.0.1', iteration_duration=780.0,

title='ndr-experiments-xf5000', verbose=True, max_iterations=10,

allowed_error=1.0, q_full_resolution=2.0,

latency_pps=0, max_latency=0, lat_tolerance=0,

output=None, yaml_file=None, plugin_file=None,

tunables={}, profile='/opt/trex/v2.82/astf/rus_ent_appmix.py', profile_tunables={},

high_mult=100, low_mult=0,

>> def some_funct(**d):

>>

>> d = {"pos_ip": "1.1.1.1000", "exception_debug": True}

>> some_funct(**d)

>> some_funct(pos_ip = "1.1.1.1000", exception_debug = True)

>> some_funct("1.1.1.1000", True)

'1.1.1.1000' does not appear to be an IPv4 or IPv6 address

False

>> def some_funct(a,**all_arg):

>> print(a, all_arg)

>> a=1

>> b=3

>> c=5

>> some_funct(a,b=5,c=7)

1 {'b': 5, 'c': 7}

Словарь вида ключ-значение (напр. kwargs) легко распарсить в переменная-значение с использованием setattr.

def get_profile(self, tunables, **kwargs):

# Assign kwargs

for key, value in kwargs.items():

setattr(self, key, value)

print(self.var1)

print(self.var2)

При использовании значений по умолчанию для переменных на входе функции, крайне нежелательно использовать массивы и другие изменяемые элементы (если не нужно именно то, что описано ниже в виде инкремента на каждый вызов list). В линтерах эта потенциальная ошибка подсвечивается как dangerous-default-value.

def some_funct(a,b,c=[]): '''some description of function''' c.append(a) c.append(b) return(c) a = 2 b = 3 print(some_funct(a,b)) print(some_funct(a,b)) print(some_funct(a,b))

[2, 3] [2, 3, 2, 3] [2, 3, 2, 3, 2, 3]

VAR basic (type, ID)

- type(var) # узнаем тип переменной

~$ python3

>>> type("Hello weril!")

<class 'str'>

>>> type(666)

<class 'int'>

>>> type(666.6)

<class 'float'>

>>> type("666.6")

<class 'str'>

>>> type(True)

<class 'bool'>

>>> type(Funct)

<class 'function'>

>>> type(None)

<class 'NoneType'>

- isinstance(25,int) # проверяем принадлежность переменной определенному типу, правильно делать именно так, а не через if type(25) == int так как isinstance принимает во внимание иерархию типов (ООП).

if not isinstance(ip, dict):

raise argparse.ArgumentTypeError('Dictionary is expected.')

- метод — функция, применяемая к объекту, напр. объекту класса string. Метод вызывается в виде

имя_объекта.имя_метода(параметры). Например,s.find('e')— это применение к строкеsметодаfindс одним параметром'e'. - str(var) # преобразование в string.

- Про строки – строка является неизменяемым (immutable) типом данных.

- Про изменяемость:

- Неизменяемые типы – str, int, float, nan, bool.

- Изменяемые типы – list, dict, set.

- Под неизменяемостью подразумевается то, что при создании нового объекта из двух строк в любом случае новая переменная будет хранится в новом месте (т.е. поменяв данные ты в любом случае меняешь ссылку на эти данные), а не как в случае изменяемых типов – переменная хранится там же, а данные меняются (т.е. поменяв данные ты сохраняешь старую ссылку на эти данные). При этом старые ячейки памяти, которые не используются, должны будут отчищены garabage collector.

- Метод

isalpha()определяет, состоит ли исходная строка из буквенных символов. Метод возвращает значениеTrueесли исходная строка является непустой и состоит только из буквенных символов иFalseв противном случае. - Метод

islower()определяет, являются ли все буквенные символы исходной строки строчными (имеют нижний регистр). Метод возвращает значениеTrueесли все буквенные символы исходной строки являются строчными иFalseв противном случае. Все неалфавитные символы игнорируются! - Метод

isupper()определяет, являются ли все буквенные символы исходной строки заглавными (имеют верхний регистр). Метод возвращает значениеTrueесли все буквенные символы исходной строки являются заглавными иFalseв противном случае. Все неалфавитные символы игнорируются! - Метод

isspace()определяет, состоит ли исходная строка только из пробельных символов. Метод возвращает значениеTrueесли строка состоит только из пробельных символов иFalseв противном случае.

>>> "sdf".isalpha() True >>> "sdf1".isalpha() False >>> "".isalpha() False >>> "sdf1".islower() True >>> "sdf&".islower() True >>> "sdF".islower() False

- int(var) # преобразование в integer. Немного оффтоп, но про integer:

- В python, в отличии от множества других языков (С*, java) integer не имеет ограничений по памяти/диапазону значений, ограничен только памятью.

- Перед преобразованием с помощью метода isdigit можно проверить, что данные являются числом (не содержат, например, символов). Метод

isdigit()определяет, состоит ли исходная строка только из цифровых символов. Метод возвращает значениеTrueесли исходная строка является непустой и состоит только из цифровых символов иFalseв противном случае. - Явно указанное численное значение в коде программы называется целочисленным литералом. Когда Python встречает целочисленный литерал, он создает объект типа int, хранящий указанное значение. В контексте литерала – строка и boolean тоже летерал (literal), противовесом литерала является контейнерных объект (containers).

- Для удобного чтения чисел можно использовать символ подчеркивания.

>>> var1=10 # целочисленный литерал >>> var1="10" >>> var1.isdigit() True >>> var1="10a" >>> var1.isdigit() False >>> var1=555_555_555 >>> var1 555555555

- float(var) # преобразование в float (число с плавающей ТОЧКОЙ, не запятой) – дробные (вещественные) числа в информатике называют числами с плавающей точкой. В отличие от математики, где разделителем является запятая, в информатике используется точка. С python3 по факту преобразования во float редко требуются т.к. при операциях с float результатом происходит автоматическая трансляция int во float – при делении двух int результатом является float – в Python3 (не Python2!, там он отбрасывает все после точки – сохраняет int тип для результата). Для сохранения остатка в python2 нужно преобразовать цифры во float.

# python3 >>> a=3/2 >>> a 1.5 >>> type(a) <class 'float'> # python2 >>> a=3/2 >>> a 1 >>> type(a) <type 'int'> # python2 >>> a=float(3)/float(2) >>> a 1.5 >>> type(a) <type 'float'>

- Метод

isalnum()определяет, состоит ли исходная строка из буквенно-цифровых символов. Метод возвращает значениеTrueесли исходная строка является непустой и состоит только из буквенно-цифровых символов иFalseв противном случае.

>>> "123abc".isalnum() True >>> "1".isalnum() True >>> "123abc!".isalnum() False >>> "".isalnum() False

- print(globals()) или print(locals()) – вывести все текущие глобальные (определенные в основном коде)/локальные переменные (определенные в функции) и их значения – очень удобно для дебага или сохранения test environment в логах (так и использовал).

- id(var) смотрим адрес переменной в памяти. Чаще всего используется только в учебных целях чтобы показать, что разные переменные ссылаются на одно место памяти при равенстве. Лучше всего демонстрируется на списках т.к. они в python изменяемые, в отличии от, например, чисел. При присвоении другого числа/строки переменной всегда переменная создается заново, ей назначается новый участок памяти, а для списка в памяти по старому адресу меняется значение. Причем какой-то родительской связи между копируемым и скопированным элементом не существует – обе переменных просто ссылаются на один участок памяти, который может изменяться при изменении любой из переменных. По этой причине копирование массивов в общем случае бессмысленно и имеет смысл только при использовании метода copy – при его использовании для новой переменной создается отдельный учаток памяти, но и он имеет подводные камни – не копирует вложенные массивы (оставляет только основной). Для этого обычно используют метод deepcopy. Все способы обхода этой проблемы ниже.

new_list = my_list doesn't actually create a second list. The assignment just copies the reference to the list, not the actual list, so both new_list and my_list refer to the same list after the assignment. # integer/string >>> var1=1000 # нужно использовать числа отличные от -5 до 256 т.к. уже хранятся в памяти (одно число всегда имеет один и тот же адрес в памяти - не создается заново), в отличии от чисел вне диапазона (каждый раз создаются в памяти заново) >>> var2=var1 >>> id(var1) 4359970544 >>> id(var2) 4359970544 >>> var1=1001 >>> id(var1) 4359970480 >>> id(var2) 4359970544 # array >>> var1=[1,2] >>> var2=var1 >>> id(var1) 4360043528 >>> id(var2) 4360043528 >>> var1[0]=3 >>> id(var1) 4360043528 >>> id(var2) 4360043528 >>> var2 [3, 2] >>> var2.append(555) >>> var2 [3, 2, 555] >>> var1 [3, 2, 555] >>> var3=var2.copy() >>> id(var2) 4317072392 >>> id(var3) 4317830152 >>> var2.append(666) >>> var2 [3, 2, 555, 666] >>> var3 [3, 2, 555]

VARIABLE SWAP (Обмен значений переменных)

Оба кода ниже делают одно – в переменной X сохраняют значение Y и наоборот (в Y значение X).

# general way (including python) temp = x x = y y = temp # python way x, y = y, x # Аналогичным образом можно менять местами значения трех и более переменных.

FLAGS (сигнальные метки)

Метка в программе после определенного условия, которая в последующем используется для принятия решения.

bag_potatoes = [2, 2, 2, 1, 2, 1, 2, 2, 2, 2] # это наш мешок, в нем 2 гнилушки

rot_flag = False # это наш флаг на гниль, сейчас у него значение фолз (ложь)

for potato in bag_potatoes: # запустим цикл перебора картошки

if potato == 1:

rot_flag = True # замечена гнилая картошка, флаг мы переводим в Тру (истина)

# ниже мы смотрим на значение флага, т.е. наших наблюдений, и делаем выводы

if rot_flag:

print('есть гнилая картошка')

print('Нужно сходить выкинуть, то что нашли')

else:

print('нет гнилой картошки')

print('Ничего выкидывать не нужно')

User Input

var = input("what are you? ") # raw_input Python2

print ("Welcome", var)

Запрос пароля, прячет символы при вводе:

>>> import getpass >>> getpass.getpass() Password: '32423424'

DIR

dir(var) – с помощью метода dir можем узнать какие методы возможно применить к объекту. Определяется типом объекта

- к строке строковые методы

- к целому числу – целочисленные

var = "test" print(dir(var)) ...['capitalize', 'casefold', 'center', 'count', 'encode']... var = 1 print(dir(var)) ...['from_bytes', 'imag', 'numerator', 'real', 'to_bytes']...

Boolean/булевые переменные (True/False) и логика

- В программировании функция, которая возвращает значение

TrueилиFalse, называется предикатом. - Примеры разных операций

>>> a = True >>> b = False >>> print(a and b) False >>> print(a or b) True >>> print(not a) False >>> print(True == 1) True >>> print(False == 0) True

- В python приоритет оператора

notвыше, чем у оператораand, приоритет которого, в свою очередь, выше, чем у оператораor. Stackoverflow, official doc.

https://stackoverflow.com/questions/16679272/priority-of-the-logical-operators-order-of-operations-for-not-and-or-in-pyth https://docs.python.org/3/reference/expressions.html#operator-precedence

- Правильное сравнение с False считается через If not

comparison to False should be 'if cond is False:' or 'if not cond:'flake8(E712) # Wrong if client_port == False: # Right if not client_port:

File (работа с файлами, Files)

Создаем файл, если он отсутствует.

if not os.path.exists(fl): os.mknod(fl)

Создаем директорию, если она отсутствует.

if not os.path.isdir(fname): Path(fname).mkdir(parents=True, exist_ok=True)

read (open default)

Классический подход чтения через with open и функцию открытия/итерирования по строкам не в одну строку, из минусов – чуть больше строк в сравнение с one-liner’ами, из плюсов – 1) невозможно забыть закрытие файла 2) в случае если объем данных большой, мы еще до добавления строки в массив можем строку отбросить/предобработать и не расходовать оперативную память ((в которую загружаются данные из файла)). one-liner’ы есть (примеры ниже), но нужно понимать, закрывают они файл по окончанию своей работы или нет (аналогичное справедливо не только для файлов – напр. открытых socket/ssh) – если нет (примеры ниже), то это в целом неправильно, хоть и будет чаще всего работать без каких либо проблем (файл закроется по завершению execution программы или после работы garbage collection).

# good classic read to array/list

l = []

with open("test.txt") as f:

for line in f:

l.append(line.rstrip())

# bad one-liner (closing issue)

def parse_file_to_list(fname):

l = open(fname).read().split("\n")

return(l)

# bad one-liner2 (closing issue) - берем login из файла, удаляем из него мусор (\n), кодируем в байт-строку

lgn = open('/home/redkin_p/.duser').read().encode('utf-8')

# bad one-liner3 (closing issue) - берем большой файл, кладем его в массив (каждая строка как элемент]), ищем в каждом элементе определенный паттерн (аналог ruby .select), выдергиваем из подпавших строк последний столбец (последний элемент каждого массива) и помещаем его в новый массив

data_list = open('/home/redkin_p/ORANGE').read().split("\n")

data_list = list(x for x in data_list if "DGS-3620" in x)

ip_list = []

for s in data_list:

ip_list.append(s.split("\t")[-1].replace(" ", ""))

print(ip_list)

write (open with w – write, a – append)

w – перезатирает файл и пишет контент в него

a – добавляет содержимое в существующий файл

# string

def write_to_file(text, fname):

with open(fname, 'a') as the_file:

the_file.write(text + "\n")

write_to_file(text, fname)

# array

with open('/home/redkin_p/result.csv', 'a') as the_file:

for n,e in enumerate(interfaces):

res = '{};{};{};{}\n'.format(e, broadcast[n], multicast[n], unknowncast[n])

the_file.write(res)

# bytes

def write_bytes_to_new_file(bytes, fname):

with open(fname, 'wb') as the_file:

the_file.write(bytes)

# string with new line and datetime (for basic logs, best logs with logging)

def write_to_file_with_new_line_and_dt(text, fname):

dt = datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S") # for log

with open(fname, 'a') as the_file:

the_file.write(str(dt) + " " + text + "\n")

write + print

Полезная функция, когда нужно вывод из print добавить формированием файла с этим print – просто подменяем print на print_write. Имя файла должно быть в GLOBALS или определенно в классе при ООП (self).

def print_write(line): print(line) write_to_file(line, global_file)

delete (удаление)

import os

os.remove("/home/redkin_p/result.csv")

copy (копирование)

from shutil import copyfile copyfile(src, dst)

seek

Перемещает позицию в файле (при итерации по файлу) в самое начало. Нужно редко, но может пригодится (напр. двойное чтение одного файла).

f.seek(0)

change/edit (изменение)

Изменение содержимого файла, как ни странно, не решаемая несколькими простыми строками кода python задача и самый “простой и надежный” способ по факту самый “тупой и прямолинейный”.

# Read in the file

with open('file.txt', 'r') as file :

filedata = file.read()

# Replace the target string

filedata = filedata.replace('ram', 'abcd')

# Write the file out again

with open('file.txt', 'w') as file:

file.write(filedata)

import os

from pathlib import Path

dirpath = "/root/"

paths = sorted(Path(dirpath).iterdir(), key=os.path.getmtime)

for fname in paths:

fname = f"{fname}" # protection from TypeError: argument of type 'PosixPath' is not iterable

Полезные методы/функции

Методы по удалению:

import os

def delete_file(fname):

try:

os.remove("{}".format(fname))

except FileNotFoundError:

pass

def delete_files_in_dir(somedir):

res = os.listdir("{}".format(somedir))

for fname in res:

fname_full_path = "{}/{}".format(somedir,fname)

delete_file(fname_full_path)

Можно использовать усовершенствованную версию – опциональный exception при ошибке удаления, удаление по маске.

def delete_file(fname, except_if_fail=False):

if except_if_fail:

os.remove("{}".format(fname))

else:

try:

os.remove("{}".format(fname))

except FileNotFoundError:

pass

def delete_files_in_dir(somedir, pattern=""):

res = os.listdir("{}".format(somedir))

for fname in res:

fname_full_path = "{}/{}".format(somedir,fname)

if pattern in fname:

delete_file(fname_full_path)

Методы по проверке наличия (isfile или exists)/ненулевому размеру (st_size != 0):

import os

def check_file_existance_boolean(file):

if os.path.isfile(file) and os.stat(file).st_size != 0:

return True

else:

return False

def check_file_existance(file):

if os.path.isfile(file) and os.stat(file).st_size != 0:

pass

else:

print("Error: нет файла {} или он имеет нулевой размер".format(file))

quit()

Расчет MD5 файла

import hashlib

def md5(fname):

hash_md5 = hashlib.md5()

with open(fname, "rb") as f:

for chunk in iter(lambda: f.read(4096), b""):

hash_md5.update(chunk)

return hash_md5.hexdigest()

Управление сервисами. Запуск функции.

check_and_change_service_status("inactive", "trex_server")

Управление сервисами. Получение статуса.

def get_service_status(service_name):

serv1_status_raw = subprocess.run("systemctl status {}".format(service_name).split(" "), stdout=subprocess.PIPE, stderr=null)

serv1_status = serv1_status_raw.stdout.decode().split("\n")[2].split()[1].replace("failed", "inactive")

return serv1_status

Управление сервисами. Установка статуса.

def set_service_status(expected_service_status, service_name):

if expected_service_status == "inactive":

expected_service_status = "stop"

elif expected_service_status == "active":

expected_service_status = "start"

else:

write_to_file_with_new_line_and_dt("real service_name {} status is {} expected is {}".format(service_name, real_status, expected_service_status), log_fname)

subprocess.run("systemctl {} {}".format(expected_service_status, service_name).split(" "), stderr=null)

Управление сервисами. Управляющая функция.

def check_and_change_service_status(expected_service_status, service_name):

real_status = get_service_status(service_name)

write_to_file_with_new_line_and_dt("real service_name {} is {} expected is {}".format(service_name, real_status, expected_service_status), log_fname)

if real_status != expected_service_status:

set_service_status(expected_service_status, service_name)

real_status = get_service_status(service_name)

if real_status != expected_service_status:

raise Exception("Can't change {} to expected value {}".format(service_name, expected_service_status), log_fname, global_log_fname)

write_to_file_with_new_line_and_dt("successfully changed {} to expected value {}".format(service_name, expected_service_status), log_fname)

CSV

Парсинг csv (отброс header, delimiter) с функцией reader.

import csv

with open('file.csv') as f:

reader = csv.reader(f, delimiter=';')

headers = next(reader)

for row in reader:

print(row)

Можно так же перевернуть массив (чтение с конца).

l = reversed(list(csv.reader(f, delimiter=';'))) for row in l:

Использование библиотеки для некоторых кейсов лучше простого split.

- можно использовать csv.DictReader вместо обычного reader для сопоставления значений в header (главное чтобы он был или в файле или заданным опцией fieldnames=[]) конкретным элементам без своего кода.

- данные ниже будут корректно разбиты по элементам при использовании библиотеки т.к. используемый разделитель “;” находится внутри кавычек.

ip;10.10.10.10;"Узловая 1-ая д.1; чердак"

Запись без библиотеки (line = строка)

write_to_file(f"{';'.join(line)}", file_with_res)

Запись через библиотеку csv

Записываем в файл список в виде строки с разделителями с функцией writerow для объекта writer. Можно использовать опцию quoting (QUOTE_NONNUMERIC, ALL) для обозначения тех данных, которые должны быть в скобках.

writer = csv.writer(f, delimiter=';', quoting=csv.QUOTE_NONNUMERIC) for line in data: writer.writerow(line)

Так же можно записать большое количество данных скопом, используя функцию writerows. В виде данных должен быть список списков (каждая строка = отдельный список).

writer = csv.writer(f, delimiter=';', quoting=csv.QUOTE_NONNUMERIC) writer.writerows(data)

Есть и аналогичная reader функция DictWriter, которая позволяет записать словарь (формат аналогичный получаемому из DictReader) с использованием writerow/writerows. При использовании есть особенность – header нужно записывать отдельно (writeheader()), даже если он задан в fieldnames к объекту.

pandas

При чтении файла в csv желательно загружать в память только нужные столбцы (usecols) этого csv. Для float, которые разделены через “,” можно так же указать опцию decimal в read.

df = pd.read_csv("/tmp/test.csv", usecols=[ "DateTime", "Packet Loss (%)" ], delimiter=";", header=24, decimal=",")

Сохранение только одного столбца по его имени в header.

Pandas is spectacular for dealing with csv files, and the following code would be all you need to read a csv and save an entire column into a variable: import pandas as pd df = pd.read_csv(csv_file) saved_column = df.column_name saved_column = saved_column.values.tolist() # transform to list # example print(df["Packet Loss (%)"])

Фильтрация – значения в столбце Stream ID должны быть равны total.

df_only_total = df[df["Stream ID"] == "total"]

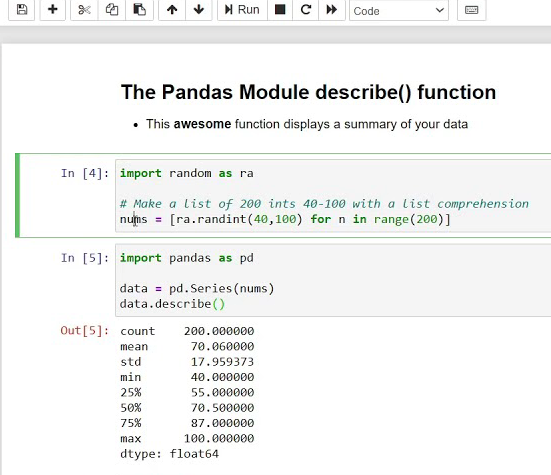

Можно применять функции mean или даже quantile/расширенного describe к столбцу – очень удобно.

print(df["Packet Loss (%)"].mean()) print(df["Packet Loss (%)"].quantile(0.75)

(статистика, python, сетевое тестирование)

В целом всегда порекомендовать делать pandas describe на выборку для получения разнообразной статистики:

-

-

-

- count 94248.000000 – количество элементов (размер выборки)

- mean 1.691554 – среднее

- std 0.979690 – стандартное отклонение (величина высокая)

- min -0.108278 – меньше этого гарантировано (на основе выборки) не будет

- 25% 0.396944 – 25% выборки выше этого значения

- 50% 2.301407 – медиана (median)

- 75% 2.348383 – 75% выборки ниже этого значения

- max 6.486859 – больше этого гарантировано (на основе выборки) не будет

-

-

Так же может дополнительно быть необходимо:

-

-

-

- 1%

- https://www.rfc-editor.org/rfc/rfc9693.html

- 80% использовал для индикации высокого результата без spike/ramp up вверх и вниз. 80ый перцентиль пример для понимания:

- 20% выборки имею результат выше

- 80% имеют результат ниже

- 95% load testing app best practice

- 99% 99th percentile, for robustness against outliers

- https://www.rfc-editor.org/rfc/rfc9693.html

- https://datatracker.ietf.org/doc/html/rfc8238

- range статистический размах

- 1%

-

-

Directory (директории, папки)

Смотрим файлы в директории

import os

for fname in os.listdir( sys.argv[1] ):

print("{}".format(fname))

Копирование директории.

from distutils.dir_util import copy_tree copy_tree(from_dir, to_dir)

Удаление директории.

import shutil

shutil.rmtree('/folder_name')

Определение текущей директории. Очень полезно для скриптов, которые оперируют относительными путями.

# current directory import os os.path.dirname(os.path.realpath(__file__))

Time: date, month, hours, seconds

Datetime

import datetime print(datetime.datetime.now())

Date-time to string

import datetime

datetime.datetime.now().strftime("%Y-%m-%d_%H%M%S") # for file_names

dt = datetime.datetime.now().strftime("%M%S.%f")[:-3] # for file_names with milkiseconds

datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S") # for general usage

# function

def get_dt() -> datetime.datetime:

dt = datetime.datetime.now()

dt_files = dt.strftime("%Y-%m-%d_%H%M%S") # для файлов

dt_logs = dt.strftime("%Y-%m-%d %H:%M:%S") # для логов

return dt_files, dt_logs

String date to date object

dt = datetime.datetime.strptime('2020-11-04', "%Y-%m-%d").date()

dt = datetime.datetime.strptime('2022-04-28 15:09:04', "%Y-%m-%d %H:%M:%S")

dt_seconds_before = (datetime.datetime.now() - dt).total_seconds()

Today

print(datetime.date.today())

Day of week (день недели), можно и на русском (см. пример в locale)

>>> from datetime import datetime as date

>>> date.today().weekday()

6

>>> date.today().strftime("%A")

'Sunday'

Datetime + seconds.

scheduled_time = datetime.datetime.now() + datetime.timedelta(seconds=5) print(datetime.datetime.now()) print(scheduled_time)

Month, можно и на русском (см. пример в locale).

>>> date.today().strftime("%B")

'August'

Определение по году (высокосный/не высокосный) и номеру месяца количества дней.

>>> from calendar import monthrange >>> monthrange(2011, 2) (1, 28) >>> monthrange(2012, 2) (2, 29)

Разность времени в секундах. Может быть полезно для расчета сколько времени прошло с запуска программы/участка кода. Напр.

- исполняем/спим до тех пор, пока время со старта не приросло на N секунд. Как только время превышено – делаем что-то другое (напр. прекращаем работу).

- спим вариативное время, т.к. execution в рамках итерации может происходить за разное время, а наша цель, чтобы каждая итерация занимала примерно одинаковое время

# BASIC EXMPL

>>> import time

>>> start_time=time.time()

>>> end_time=time.time() - start_time

>>> end_time

15.806370258331299

>>> end_time=time.time() - start_time

>>> end_time

24.918872117996216

# USAGE 1 тестируем пока не закончилось время

while (time.time() - test_start_time < test_time):

print("test code")

# USAGE 2 замедляем итерирование в скрипте на основе времени для каждой итерации.

elapsed_time = time.time() - start_time

need_to_sleep = speed - elapsed_time

time.sleep(need_to_sleep)

В коде выше используется time.time конструкция, которая может быть замененаа time.perfcounter. time.perfcounter стоит использовать при наличии требований по высокой точности (микросекунды), например, задач измерения производительности кода/максимально точных интервалов между запусками и с учетом, что:

1) выдаваемое время не привязано к “человеческому”

2) валидно сравнивать только time.perfcounter с time.perfcounter

https://stackoverflow.com/questions/66036844/time-time-or-time-perf-counter-which-is-faster time.time() - deals with absolute time, i.e., "real-world time" (the type of time we're used to). It's measured from a fixed point in the past. According to the docs, time.time() returns time. perf_counter() - on the other hand, deals with relative time, which has no defined relationship to real-world time (i.e., the relationship is unknown to us and depends on several factors). It's measured using a CPU counter and, as specified in the docs, should only be used to measure time intervals: The reference point of the returned value is undefined, so that only the difference between the results of consecutive calls is valid. Because of that, time.perf_counter() is mostly used to compare performance.

Math (математика, статистика)

База

Приоритеты: a = 82 // 3 ** 2 % 7= 82 // 9 % 7 = 9 % 7 = 2

| Оператор | Описание |

|---|---|

| + | сложение |

| – | вычитание |

| * | умножение |

| / | деление |

| ** | возведение в степень, имеет наивысший приоритет, правоассоциативно 2 ** 2 ** 3 = 256 |

| % | остаток от деления, приоритет аналогичен делению/умножению

10 % 3 = 1

|

| // | целочисленное деление, приоритет аналогичен делению/умножению

10 // 3 = 3 10 // 12 = 0 -10 // 3 = -4 |

Отходящую от базовой калькуляции можно делать со стандартной библиотекой math. Далее, по аналогии с re (regexp), можно вызывая модуль объект math применять функции (или извлекать данные, например значение числа pi), определенные в этом модуль-объекте через точку (dot-notation).

import math math.pi # число PI math.sin(radians) math.log10(ratio) math.sqrt(2) # квадратный корень числа, заменяется возведением в степень 1/2: n ** 0.5 The module object contains the functions and variables defined in the module. To access one of the functions, you have to specify the name of the module and the name of the function, separated by a dot (also known as a period). This format is called dot notation. dot notation - The syntax for calling a function in another module by specifying the module name followed by a dot (period) and the function name.| log(x) | Натуральный логарифм числа x. Основание натурального логарифма равно числу e |

| log10(x) | Десятичный логарифм числа x. Основание десятичного логарифма равно числу 10 |

| log(x, b) | Логарифм числа x по основанию b, напр: math.log(100, 2) |

| factorial(n) | Факториал натурального числа n |

Округление к большему (round up) делается с помощью функции ceil.

import math print(math.ceil(4.2))

Округление к меньшему с помощью функции floor. Но можно 1) использовать деление на цело // вместо обычного 2) преобразовать float в int

import math print(math.floor(4.2))

Среднее значение (average/mean value) для списка (массива).

import statistics first_values_avr = statistics.mean(first_values) last_values_avr = statistics.mean(last_values)

Медиана. Почему часто лучше использовать медиану описано тут (с примером).

Пример расчет в python: >>> import statistics >>> l = [25, 17, 23, 18, 24, 23, 16, 85, 50] >>> statistics.mean(l) 31.22222222222222 >>> statistics.median(l) 23 Наглядно между какими значениями находится среднее (23) и медиана (31): 16 17 18 23 23 24 25 50 85

Процентиль (numpy).

# PYTHON

>> import numpy as np

>> a = np.array([1,2,3,4,5])

>>> p = np.percentile(a, 50)

>>> print(p) 3.0

Коэффициент корреляции (correlation coefficient).

import numpy #a = list(map(int, a)) # example for data from file #b = list(map(int, b)) # example for data from file a = [1,4,6] b = [1,2,3] print(numpy.corrcoef(a,b)[0][1])

| Количественная мера тесноты связи |

Качественная характеристика силы связи |

| 0,1-0,3 | Слабая |

| 0,3-0,5 | Умеренная |

| 0,5-0,7 | Заметная |

| 0,7-0,9 | Высокая |

| 0,9-0,99 | Весьма высокая |

Линия тренда в математическом виде (судя по всему рассчитанная на основе метода наименьших квадратов).

Несколько интересных задач с использованием целочисленного деления и остатка деления (stepik Поколение Python)

- При помощи операции нахождения остатка и целочисленного деления можно достаточно несложно вычислить любую цифру числа. Чтобы получить последнюю цифру любого числа, нужно найти остаток от деления числа на 10.

Рассмотрим программу получения цифр трёхзначного числа:

num = 754 a = num % 10 b = (num % 100) // 10 c = num // 100 print(a) print(b) print(c) >>> 4 5 7

Алгоритм получения цифр n-значного числа

Первая цифра: (num % 10^n) // 10^n-1 Последняя цифра: (num % 10) // 100 3 # num % 10

- Напишите программу для пересчёта величины временного интервала, заданного в минутах, в величину, выраженную в часах и минутах.

mn = int(input()) print(mn, "мин - это", mn//60, "час", mn%60, "минут.")

- Безумный титан Танос собрал все 6 камней бесконечности и намеревается уничтожить половину населения Вселенной по щелчку пальцев. При этом если население Вселенной является нечетным числом, то титан проявит милосердие и округлит количество выживших в большую сторону. Помогите Мстителям подсчитать количество выживших.На вход дается число целое n – население Вселенной. Программа должна вывести одно число – количество выживших.

Номер теста Входные данные Выходные данные 1 99 50 2 1132 566 3 1 1 Решил так: a//2+a%2 Так же решение: (a+1)//2

- В купейном вагоне имеется 9 купе с четырьмя местами для пассажиров в каждом. Напишите программу, которая определяет номер купе, в котором находится место с заданным номером (нумерация мест сквозная, начинается с 1). На вход программе подаётся целое число – место с заданным номером в вагоне. Программа должна вывести одно число – номер купе, в котором находится указаное место.

Номер теста Входные данные Выходные данные 1 1 1 2 2 1 3 3 1 4 4 1 5 5 2 6 6 2 7 7 2 8 8 2 9 9 3 10 10 3 Решил так (не совчем честно тк не проходили float): int(a//4.1+1) Более кошерное решение: (a - 1) // 4 + 1

Комментарии

В целом о комментариях и их использовании тут.

Simple comment:

# comment

Multiline Code, Variable, Comment (многострочный код/переменная комменты)

Полезно когда много всего в одной строке расщеплять ее на несколько:

Import

from some_module import 1, 2, 3, 4, 5, 6, \ 6, 7, 8, 9, 10, \ 11, 12, 13,14

Variable

msg = f"Error: retry ({i}/{i_max}) receive data is not ready" + \

"to read (not buffered), waiting 2 seconds..."

Comment

# - обычный однострочный ''' или """ - multiline

Как правильно разбивать длинные строки кода.

The preferred way of wrapping long lines is by using Python’s implied line continuation inside parentheses, brackets and braces.

Long lines can be broken over multiple lines by wrapping expressions in parentheses. These should be used in preference to using a backslash for line continuation.

# 1 my_sum = (0 + 1 + 2 Break up line + 3 + 4 + 5 + 6 + 7 + 8) # 1-2 from trex_stl_lib.api import (STLClient, Ether, STLScVmRaw, STLVmFlowVar, STLVmWrFlowVar, STLVmFixIpv4, STLPktBuilder, STLStream, STLTXCont, STLError) # 2 assert True == True, \ 'This is a very long error message that should be put on a separate line'

Variable

var = '''line1 line2 line3'''

Очень удобно multiline использовать для более-менее симпатичного пользовательского вывода в CLI. Пример вывода информаци о VM Azure:

print(f'''Key VMs info:

name: {vm_info["name"]}

size: {vm_info["hardwareProfile"]["vmSize"]}

location: {vm_info["location"]}

proximityPlacementGroup: {ppg}

nics: {json.dumps(nics, indent=10)}

''')

Random

Библиотека random позволяет генерировать псевдо-случайные числа.

The random module provides functions that generate pseudorandom numbers (which I will simply call "random" from here on).

В random есть глобальная (для функций random) возможность использовать random seed для генерации псевдослучайного распределения. Чтобы повторять результат random можно заранее задекларировать seed (при вызове любой функции рандомизации будет использован этот seed), чтобы иметь каждый раз (каждый вызов функции) разный результат – сбросить seed. При этом, в документации python гарантируется, что несмотря на реальные будущие изменения алгоритмов в стандартной библиотеке random, при использовании одного seed value будет получаться одинаковое псевдорандомное распределение. Примеры использования повторяемого рандома (random seed/repeatable random) – токены MFA, генераторы трафика: tcpreplay-edit, isic, TRex, Ixia IxNetwork.

random.seed(1) # declare seed random.seed() # reset seed (use random seed) https://docs.python.org/3/library/random.html Most of the random module’s algorithms and seeding functions are subject to change across Python versions, but two aspects are guaranteed not to change: - If a new seeding method is added, then a backward compatible seeder will be offered. - The generator’s random() method will continue to produce the same sequence when the compatible seeder is given the same seed.

Функция .random к объекту random генерирует случайное число от 0.1 до 1.

The functionrandomreturns a random float between 0.0 and 1.0 (including 0.0 but not 1.0). import randomrandom.random()

Функция .randint к объекту random генерирует случайное int число от заданного x до y.

The functionrandinttakes the parameterslowandhigh, and returns an integer betweenlowandhigh(including both).random.randint(3, 10)

Функция .choice к объекту random выбирает случайный элемент из массива.

To choose an element from a sequence at random, you can use choice

random.choice([1, 4, 2, 5])

random.choice([5,7,9,11,10,31,32,34])

>>> import random

>>> random.choice([5,7,9,11,10,31,32,34])

7

>>> random.choice([5,7,9,11,10,31,32,34])

31

>>> random.choice([5,7,9,11,10,31,32,34])

7

>>> random.choice([5,7,9,11,10,31,32,34])

10

>>> random.choice([5,7,9,11,10,31,32,34])

7

Функция shuffle перемешивает массив.

# BASIC from random import shuffle x = [[i] for i in range(10)] shuffle(x) print(x) >> [[5], [1], [8], [4], [6], [3], [9], [2], [7], [0]]

Кодировка (Coding), utf-8, ascii, encode, decode, ENCODING

- В Python строки хранятся в виде последовательности Unicode символов.

- Подробнее о таблицах символов ascii/unicode и кодировках utf-8/16/32 в словаре.

- Пример вывода всех ASCI символов

>>> import string >>> print(string.ascii_letters) abcdefghijklmnopqrstuvwxyzABCDEFGHIJKLMNOPQRSTUVWXYZ >>> print(string.ascii_letters[0]) a >>> print(string.ascii_letters[5]) f

- Всегда лучше указывать кодировку в header файла. Может помочь от ошибок типа “Non-ASCII character ‘\xc2’ in file” и открывать файлы со скриптами в utf-8 на Windows без преобразований в другие кодировки.

# -*- coding: utf-8 -*-

Для кодирования символов в byte строку используем encode. Можно применять на саму строку или на класс str. Если символы не поддерживаются в таблице символов – будет ошибка. Можно указать разные опции (костыли), что делать с символами, которые не распознаются (ignore, replace, namereplace).

>>> print("привет".encode("utf-8")) b'\xd0\xbf\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82' >>> print(str.encode("привет","utf-8")) b'\xd0\xbf\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82'

>>> print("привет".encode("ascii")) Traceback (most recent call last): File "<stdin>", line 1, in <module> UnicodeEncodeError: 'ascii' codec can't encode characters in position 0-5: ordinal not in range(128) >>> print("привет".encode("ascii","ignore")) b'' >>> print("привет".encode("ascii","replace")) b'??????' >>> print("привет".encode("ascii","namereplace")) b'\\N{CYRILLIC SMALL LETTER PE}\\N{CYRILLIC SMALL LETTER ER}\\N{CYRILLIC SMALL LETTER I}\\N{CYRILLIC SMALL LETTER VE}\\N{CYRILLIC SMALL LETTER IE}\\N{CYRILLIC SMALL LETTER TE}'

Для кодирования чисел (integer) в byte используем to_bytes. Пример str to bytes и integer to bytes в формировании DNS запросов для scapy payload.

full_payload = '\x00\x00\x01\x00\x00\x01\x00\x00\x00\x00\x00\x00\x05\x77\x65\x72\x69\x6c\x02\x6d\x65\x00\x00\x01\x00\x01' # эталон

payload_prepend = b'\x00\x00\x01\x00\x00\x01\x00\x00\x00\x00\x00\x00'

payload_append = b'\x00\x00\x01\x00\x01'

domain = b''

domain_str = 's1.d1.weril.me'

domain_dot_number = 0

chr_num = 0

for chr in domain_str:

if chr == "." or chr_num == 0:

domain1_len = len(domain_str.split(".")[domain_dot_number])

byte_int = domain1_len.to_bytes(1, 'big')

domain = domain + byte_int

domain_dot_number = domain_dot_number + 1

if chr_num == 0:

domain = domain + chr.encode()

else:

domain = domain + chr.encode()

chr_num = chr_num + 1

full_payload = payload_prepend + domain + payload_append

pkt = Ether()/IP(src="16.0.0.1",dst="48.0.0.1")/UDP(sport=1025)/(full_payload)

Для декодирования символов из byte строки используем decode. При декодировании нужно знать исходную кодировку, иначе (если кодировка кодирования и декодирования не совпадают, например utf-8 – utf-16) могут декодироваться кракозябры или может быть ошибка декодирования (можно так же как в случае с кодированием игнорировать недекодируемые символы). Поэтому желательно указывать кодировку в header файла (см. выше).

>>> print(b'\xd0\xbf\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82'.decode("utf-8")) привет >>> print(bytes.decode(b'\xd0\xbf\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82',"utf-8")) привет

>>> print(b'\xd0\xbf\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82'.decode("utf-16")) 뿐胑룐닐뗐苑

UnicodeDecodeError: 'utf-8' codec can't decode byte 0xff in position 0: invalid start byte UnicodeDecodeError: 'ascii' codec can't decode byte 0xd0 in position 0: ordinal not in range(128) hi_unicode = 'привет' hi_bytes = hi_unicode.encode('utf-8') hi_bytes.decode('ascii',"ignore")

num2words library – Convert numbers to words in multiple languages – позволяет конвертировать числа в пропись, полезно для бугалтерии/документов с деньгами.

$ num2words 10001

ten thousand and oneПо умолчанию кодировка для Linux/MAC – UTF-8, для Windows – зависит от языка системы, в случае русского это cp1251.

Lin >>> import locale >>> locale.getpreferredencoding() 'UTF-8' Win >>> import locale >>> locale.getpreferredencoding() 'cp1251'

Строку из UTF-8 преобразовать в CP1251 легко. Напр. может пригодиться тогда, когда программа исполняется с utf-8 кодировкой (под исполняется – имеет комментарии/оперирует с базой/сохраняет вывод/etc с utf-8 символами) но какой-то или весь вывод нужно сохранить в cp1251 – формируем какой-нибудь CSV файл, который будет открываться в Windows.

"привет".decode("utf-8").encode("cp1251",'ignore') # convert from UTF-8 to cp1251

Пример изменения locale для отображения дней недели/месяцов на русском стандартными функциями.

>>> import locale

>>> locale.setlocale(locale.LC_ALL, ('ru_RU', 'UTF-8'))

'ru_RU.UTF-8'

>>> date.today().strftime("%B")

'августа'

>>> date.today().strftime("%A")

'воскресенье'

Большинство библиотек, которые работают с внешними данными (файлы, подключения по сети и к базам данными) позволяют указать кодировку данных непосредственно при вызове. Например, subprocess, file. Каким то библиотекам данные обязательно нужны в виде byte (telnetlib).

test = subprocess.run(cmd, stdout=subprocess.PIPE, stderr=subprocess.PIPE, encoding='utf-8') # декодируем полученные байты в строку

>>> open('/home/redkin_p/sw') <_io.TextIOWrapper name='/home/redkin_p/sw' mode='r' encoding='UTF-8'>

Особенность python – байт строку с ascii символами python автоматически декодирует (показывает симолы вместо byte) при отображении, при этом не меняя тип. При этом к byte строке можно применить методы строк типо uppper и это создает еще большую иллюзию, что идет работа с с символами, а не байтами. Если символы не ascii – python показывает сырые байты, как они есть (as is). В случае перемешки ascii и не-ascii происходит отображение в виде символов того, что удалось конвертировать.

>>> print("hi".encode("utf-8")) b'hi' >>> print("привет".encode("utf-8")) b'\xd0\xbf\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82' >>> print(type("привет".encode("utf-8"))) <class 'bytes'> >>> print(type("hi".encode("utf-8"))) <class 'bytes'>

>>> print("hello and привет".encode("utf-8")) b'hello and \xd0\xbf\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82'

Функция ord() принимает на входе символ (одиночный символ) и возращает его код в таблице символов Unicode.

num1 = ord('A')

num2 = ord('B')

num3 = ord('a')

print(num1, num2, num3)

>>>

65 66 97Функция chr() по коду символа возвращает строку (str) с символом Юникода.

>>> chr(97)

'a'

>>> chr(98)

'b'

>>> chr(122)

'z'

a = "weril.me"

for s in a:

code = ord(s)

print(f"s:{s}, codecode:{code}")

s:w, code:119

s:e, code:101

s:r, code:114

s:i, code:105

s:l, code:108

s:., code:46

s:m, code:109

s:e, code:101

a = "weril.me"

for s in a:

code = ord(s)

reverse = chr(code)

print(f"s:{s}, code:{code}, reverse:{reverse}")

s:w, code:119, reverse:w

s:e, code:101, reverse:e

s:r, code:114, reverse:r

s:i, code:105, reverse:i

s:l, code:108, reverse:l

s:., code:46, reverse:.

s:m, code:109, reverse:m

s:e, code:101, reverse:e

# Мы можем использовать следующий код для вывода всех заглавных букв английского алфавита:

for i in range(26):

print(chr(ord('A') + i))

# На вход программе подаются два числа a и b. Напишите программу, которая для каждого кодового значения в диапазоне от a до b(включительно), выводит соответствующий ему символ из таблицы символов Unicode

num1=int(input())

num2=int(input())

for n in range(num1, num2+1):

print(chr(n), end=" ")

# На вход программе подается строка текста. Напишите программу, которая переводит каждый ее символ в соответствующий ему код из таблицы символов Unicode.

num=input()

for n in num:

print(ord(n), end=" ")

Telnet

При использовании telnetlib с python 3+ обязательно кодируем в байт строку данные иначе будет выдавать ошибку TypeError: ‘str’ does not support the buffer interface (python 3.4) или TypeError: a bytes-like object is required, not ‘str’ (python 3.6). Это можно сделать поставив символ “b” перед строкой или применив к нему метод encode (с кодировкой utf-8/ascii или без указания кодировки). Полученные данные в str декодируем в байт строку через decode.

#!/usr/bin/env python3.6

#coding: utf-8

import telnetlib

# bad one-liner read (closing issue) (see above)

lgn = open('/home/redkin_p/.duser').read().rstrip().encode('utf-8') #берем login из файла, удаляем из него мусор (\n), кодируем в байт-строку

pswd = open('/home/redkin_p/.dpass').read().rstrip().encode('ascii') #берем password из файла, удаляем из него мусор (\n), кодируем в байт-строку

tn = telnetlib.Telnet("10.10.10.10") #подключаемся к узлу

tn.read_until("UserName:".encode()) #ждем строку "UserName:"

tn.write(lgn + b"\r") #передаем кодированный в байт-строку login

tn.read_until(b"PassWord:") #ждем строку "PassWord:"

tn.write(pswd + b"\r") #передаем кодированный в байт-строку password

tn.read_until(b"#") #ждем строку "#"

tn.write(b"show switch\r") #передаем необходимый запрос

res = tn.read_until(b"#") #забираем данные, можно так же использовать функцию read_very_eager() на объект telnetlib.

tn.close

print(res.decode('ascii')) #

SSH

Для ssh используем paramiko.

Функции подключения по ssh и отправке команд в созданный connect.